Gaia-X Use Cases - Ein Interview mit Jann Wendt

Über 70 Gaia-X-Pilotprojekte entwickeln zurzeit die technischen Anforderungen für Europas künftiges Cloud-Ökosystem. Das Konsortium für “Smart...

Der kürzlich erschienene Hydro International-Artikel "The Pressure Beneath the Surface" (Der Druck unter der Oberfläche) fasst eine Realität zusammen, die viele Unterwasser- und Hydrographieexperten nur zu gut kennen: Der Druck ist nicht mehr nur physisch, sondern auch digital. Zunehmende Vermessungshäufigkeit, Sensoren mit höherer Auflösung, wachsende Offshore-Anlagen und kürzere Lieferfristen erzeugen einen enormen Datendruck und bringen die bestehenden Daten-Workflows an ihre Grenzen.

Was in dem Artikel hervorsticht, ist nicht die Neuartigkeit der Herausforderungen, sondern die Vertrautheit in den Bereichen Offshore-Windkraft, Unterwasserkabel, Meeresinfrastruktur und Verteidigung. Die Branche kämpft nicht damit, Daten zu sammeln. Sie kämpft vielmehr darum, mit den Daten umzugehen.

Dies ist keine futuristische Aussicht, sondern die heutige Realität vieler Unterwasser- und Hydrographieexperten. Und was noch wichtiger ist: Es gibt bereits Lösungen für diese Herausforderungen.

Moderne Unterwasserarbeiten sind auf akustische Sensoren angewiesen, um das Unsichtbare sichtbar zu machen. Fächerecholote, Side-Scan-Sonare, Sub-Bottom-Profiler und ähnliche Systeme erzeugen außerordentlich detaillierte Darstellungen des Meeresbodens und des Untergrunds. Jede Vermessung liefert einen immensen Wert, aber auch Terabytes an komplexen, unstrukturierten Rohdaten.

Hydro International weist zu Recht auf mehrere Druckpunkte hin:

Diese Belastungen sind keine isolierten technischen Probleme. Sie sind systemischer Natur. Und sie verschärfen sich noch, wenn die Projekte größer werden, die behördliche Kontrolle zunimmt und die Gewinnspannen kleiner werden.

In vielen Unternehmen verbringen hochqualifizierte Geophysiker und Hydrographen einen großen Teil ihrer Zeit mit dem Auffinden, Verschieben, Öffnen und Überprüfen von Daten, anstatt sie zu interpretieren. Dies ist kein Qualifikationsproblem. Es ist ein Problem der Datenverwaltung und -architektur.

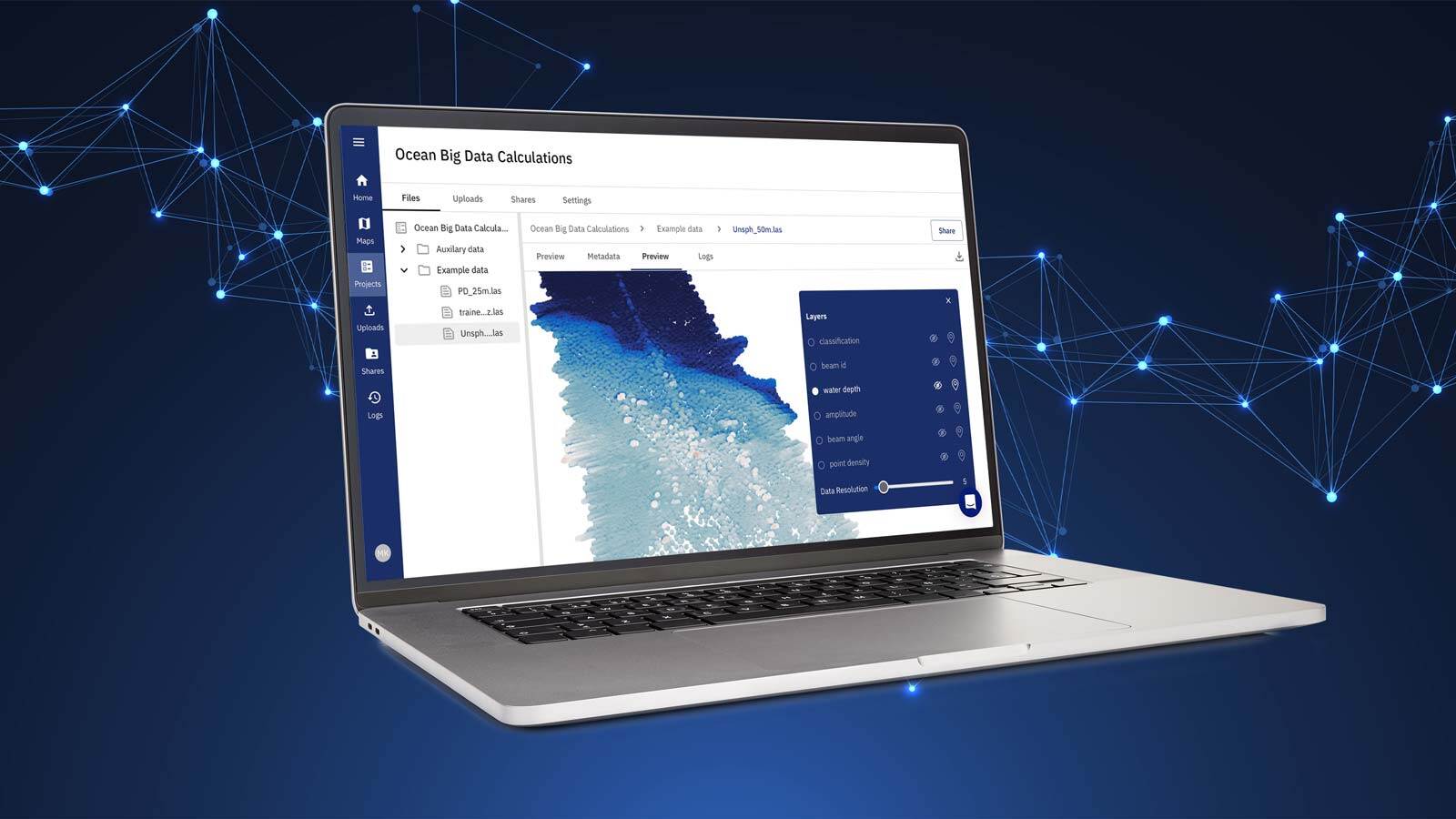

Was wir als Ocean Big Data bezeichnen, spiegelt einen grundlegenden Wandel in der Art und Weise wider, wie Unterwasserinformationen erzeugt und genutzt werden. Rohdaten von Unterwassersensoren erfüllen heute eindeutig alle drei Dimensionen von Big Data:

Dennoch stützt sich ein Großteil der Branche immer noch auf Softwareparadigmen und Arbeitsabläufe, die in den 1990er Jahren entwickelt wurden: als die Datensätze kleiner waren, die Erhebungen seltener stattfanden und die Zusammenarbeit lokal war.

Die Folge sind Reibungsverluste überall: doppelte Daten, manuelle Übergaben, stichprobenartige Qualitätskontrollen und lange Rückkopplungsschleifen zwischen Vermessungs-, Ingenieur- und Entscheidungsteams.

Genau hier liegt der Ursprung des in Hydro International beschriebenen Drucks.

Was der Artikel von Hydro International andeutet, sind aufkommende Themen. Tatsächlich vollzieht sich der technologische Wandel bereits unter der Oberfläche des Tagesgeschäfts.

In der gesamten Branche bewegen sich die Lösungsanbieter weg von:

Und hin zu:

All dies zielt darauf ab, das Urteilsvermögen von Experten zu unterstützen und die Reibungsverluste zu beseitigen, die Experten daran hindern, ihr Wissen und ihre Erfahrung dort einzusetzen, wo es am wichtigsten ist.

Wenn Unterwasser-Rohdaten zentral zugänglich, räumlich indiziert und bei der Aufnahme technisch validiert werden, ändern sich gleich mehrere Dinge:

Für all dies ist keine futuristische Technologie erforderlich. Es erfordert die Anwendung bewährter Big-Data-Prinzipien (die in anderen Branchen bereits Standard sind) auf die Realitäten des Unterwasserbetriebs.

Eine der kritischsten Datenbelastungen in der Branche ist die Qualitätskontrolle (QC). Da die Datenmengen schneller wachsen als die Teams, wird die Qualitätskontrolle oft selektiv, manuell und unter Zeitdruck durchgeführt.

Dadurch entsteht eine unangenehme Kluft zwischen den Kosten der Datenerfassung und dem Vertrauen in die Verwendbarkeit der Daten.

Moderne Ansätze schließen diese Lücke durch eine Kombination:

Das Ergebnis ist nicht nur eine schnellere Qualitätskontrolle, sondern auch das Vertrauen in die Daten und die Investitionsrentabilität bei großen Vermessungsaufträgen.

Der Druck unter der Oberfläche ist real. Er kann jedoch auch in eine operative Chance umgewandelt werden.

Wir befinden uns in einer Übergangsphase, in der die Unterwasser- und Offshore-Industrie erkennt, dass die vorhandenen Dateninfrastrukturen nicht mehr in der Lage sind, die wachsenden Datenmengen zu bewältigen.

Es gibt bereits Lösungen, die die von Hydro International beschriebenen Engpässe beheben. Es handelt sich dabei nicht um Patentrezepte, und es geht auch nicht darum, menschliches Fachwissen abzuschaffen. Es geht darum, die Skalierung zu ermöglichen.

Ocean Big Data ist nicht einfach ein Nebenprodukt des Offshore-Betriebs. Es ist die digitale Grundlage, die es ermöglicht, dass diese Tätigkeiten in einer zunehmend komplexen Meeresumgebung sicher, effizient und wirtschaftlich lebensfähig bleiben.

Die Unternehmen, die diesen Wandel frühzeitig erkennen, werden nicht nur Druck abbauen, sondern ihn in einen Wettbewerbsvorteil verwandeln.

Über 70 Gaia-X-Pilotprojekte entwickeln zurzeit die technischen Anforderungen für Europas künftiges Cloud-Ökosystem. Das Konsortium für “Smart...

Das rasche Wachstum von Offshore-Windparks hat zu einem erhöhten Bedarf an genauen und zuverlässigen Daten und Datenmanagement geführt. Die...

Die meisten geophysikalischen Meeresuntersuchungen folgen einem ähnlichen Arbeitsablauf, wie in Abbildung 1 dargestellt. Datenqualitätsprüfungen sind...

Am 26. Januar nahm north.io an der Gaia-X Werkstatt VIII teil. Diese Veranstaltung widmete sich der Standardisierung in der Datenökonomie. Dabei...

.png)